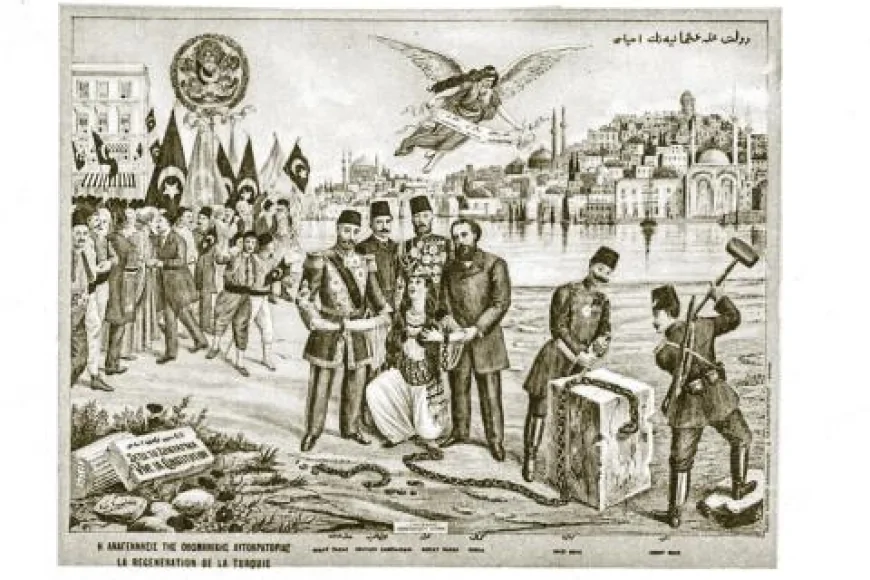

Miniklerden geçmişe yolculuk: Kostümlerle büyükanne ve büyükbaba oldular

Haber Merkezi Mar 26, 2025

Ramazan Bayramı öncesi Keçiören'de tatlıcıdan markete her yer denetlendi

Haber Merkezi Mar 27, 2025

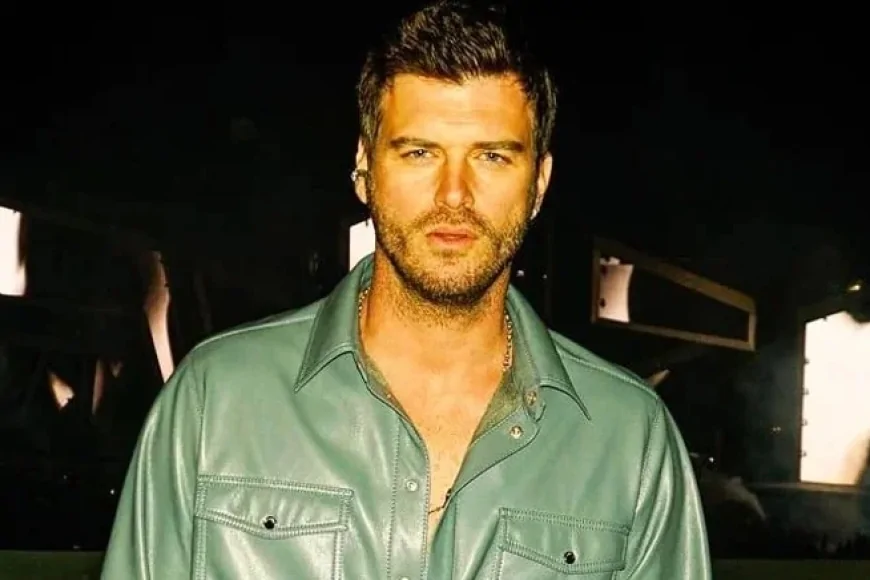

Eser Yenenler: '3 Adam kariyerimin dönüm noktası oldu, sunuculuğu daha çok seviyorum'

Haber Merkezi Mar 27, 2025

Ankara'da Ergenlik Dönemindeki Gençlere ve Annelerine Yönelik Geniş Katılımlı Eğitim Semineri Düzenlendi

Haber Merkezi Mar 26, 2025

Altındağ’da Miniklerden Yaşlılara Duygu Dolu Ziyaret: 'Unutulmaz Bir Anı Oldu'

Haber Merkezi Mar 26, 2025

Çankaya'da Miniklere Zabıta Dersi: Görevlerini Anlattılar, Hediyelerle Uğurladılar

Haber Merkezi Mar 26, 2025

Emeklilerden Shakespeare Yorumu: 'Romeo ve Juliet' İzleyicilerden Tam Not Aldı

Haber Merkezi Mar 26, 2025

Miniklerden geçmişe yolculuk: Kostümlerle büyükanne ve büyükbaba oldular

Haber Merkezi Mar 26, 2025

Ramazan Bayramı öncesi Keçiören'de tatlıcıdan markete her yer denetlendi

Haber Merkezi Mar 27, 2025

Eser Yenenler: '3 Adam kariyerimin dönüm noktası oldu, sunuculuğu daha çok seviyorum'

Haber Merkezi Mar 27, 2025

Ankara'da Ergenlik Dönemindeki Gençlere ve Annelerine Yönelik Geniş Katılımlı Eğitim Semineri Düzenlendi

Haber Merkezi Mar 26, 2025

Altındağ’da Miniklerden Yaşlılara Duygu Dolu Ziyaret: 'Unutulmaz Bir Anı Oldu'

Haber Merkezi Mar 26, 2025

Çankaya'da Miniklere Zabıta Dersi: Görevlerini Anlattılar, Hediyelerle Uğurladılar

Haber Merkezi Mar 26, 2025

Emeklilerden Shakespeare Yorumu: 'Romeo ve Juliet' İzleyicilerden Tam Not Aldı

Haber Merkezi Mar 26, 2025

Miniklerden geçmişe yolculuk: Kostümlerle büyükanne ve büyükbaba oldular

Haber Merkezi Mar 26, 2025